【论文阅读】Text Level Graph Neural Network for Text Classification (EMNLP 2019)

Motivation

传统的针对文本分类的GNN通常是构建一个固定的corpus level的图,这种图一般是静态图,有如下特征和缺点:

- Corpus level,一般事先将所有的文档建模到图中。但这会使得计算资源消耗大,并且不可动态地增加文档,不可以进行online test。

- 边的权重预先设定好,不可更改。受到预先设定的限制,并且降低了边的表达能力。

所以针对以上缺点,本文提出了一种新的文档级别的GNN方法。

Method

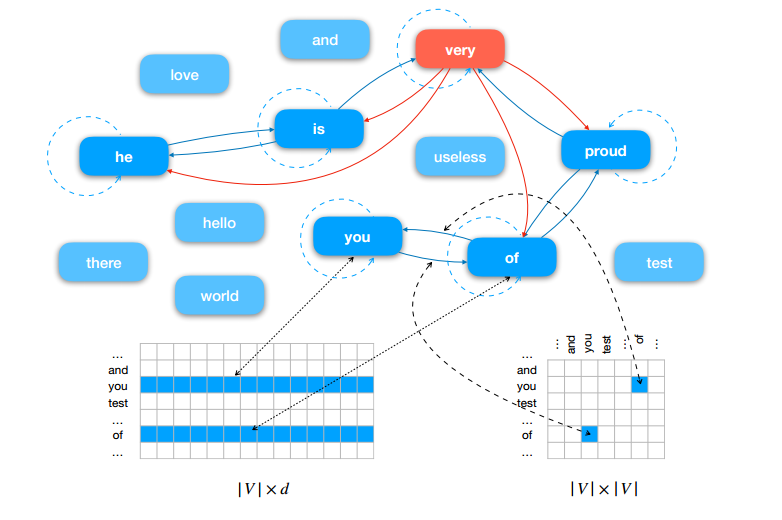

建图

首先,有两个个全局共享的参数:词的表示(Embedding),边的关系(Embedding)。针对每个文档,设定一个大小为p的滑动窗口,如果两个词在这个窗口共同出现,则有一条边相连。边和点的初始化都是从全局参数中取出,而且可学习。由于图减小,计算量也会减小。而且由于是以文档为基础进行建图,所以可以添加新的文档。

更新

对图的更新使用了一个消息传播机制,即一个点的表示会受到相邻的点的影响,所以这个点的更新应该基于这个点原来的表示和周围的点的表示。

$$M_n = max(e_{an}r_a)$$

$$r'_n = (1-\eta_n)M_n+\eta_nr_n$$

预测

最后对整个文档所有的点求和,得到最终的表示并进行分类。

$$y_i = softmax(Relu(W\sum_{n \in N_i}{r'_n}+b))$$

Experiments

- 该方法优于现有的文本分类的CNN、LSTM和图方法。

- 该方法所需的memory仅为Text-GCN的1/10左右。

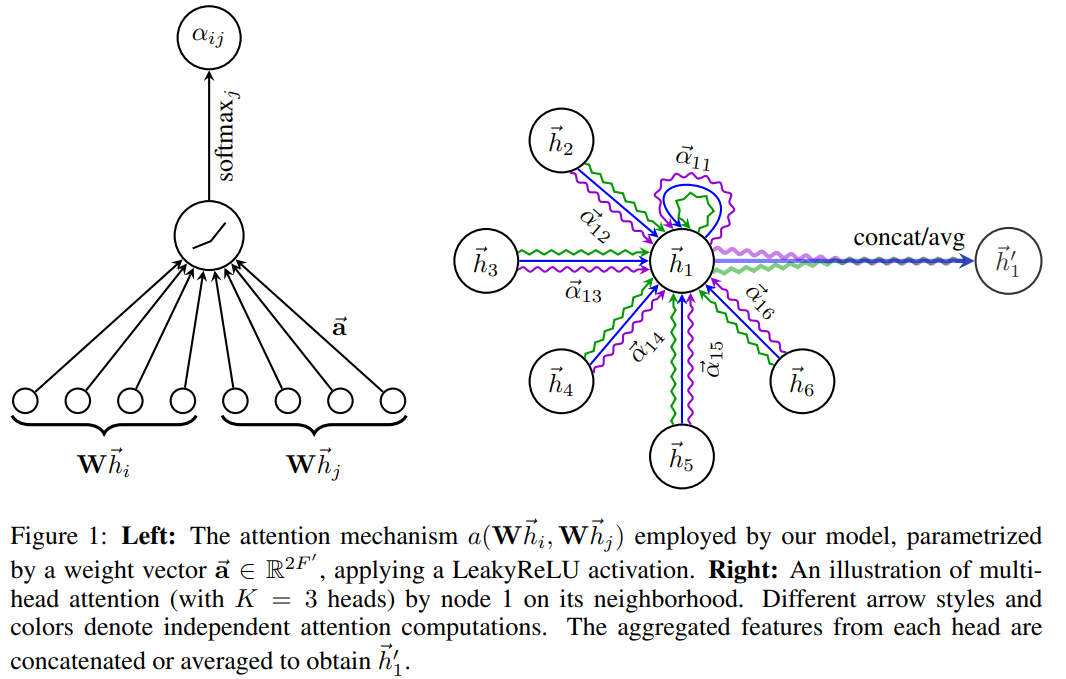

补充材料 Graph Attention Network (ICLR 2018)

https://arxiv.org/pdf/1710.10903.pdf

这是一篇将attention机制应用到graph convolution中的文章。Attention机制的特点是,它的输入向量长度可变,通过将注意力集中在最相关的部分,以此做出决定。attention机制结合RNN或者CNN的方法,在许多任务上取得了不错的表现。

by Mikito

by Mikito