【论文阅读】Topic model + 监督任务论文小结

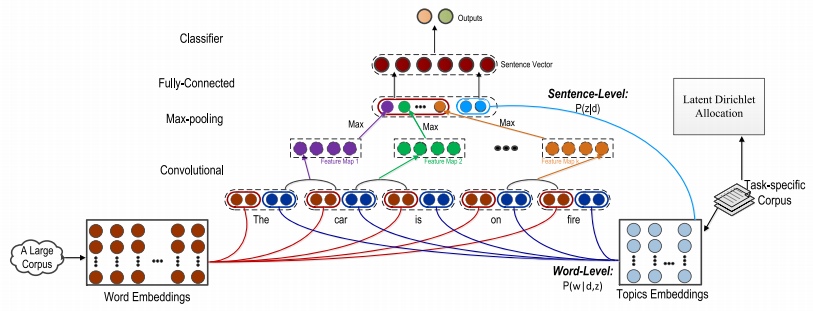

Topic-Aware Deep Compositional Models for Sentence Classification(2017)

2017年的一篇文章,还没用到NTM,是pre-train的TM。论文整体不复杂,就是对于一个单词同时使用pre-train的word embedding和TM得到的topic embedding(这个是word的topic embedding,维度为1 * K)。然后输入到一个deep compositional model得到最终表示。multisense这个词用的觉得新鲜。

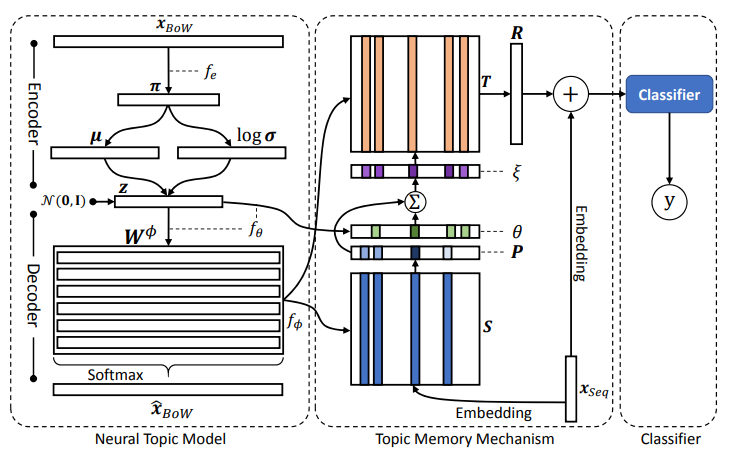

Topic Memory Networks for Short Text Classification(EMNLP 2018)

不知道是不是第一篇,但是一开始看到这篇论文的时候觉得想法挺好的。将TM+MN的方式来引入topic,并且将文档的topic distribution加到attention weight上面,结构和引入的方式融合的挺好,而且还开源了代码。不过论文方法部分与实际代码有出入。

Heterogeneous Graph Attention Networks for Semi-supervised Short Text Classification(EMNLP 2019)

这是EMNLP 2019的一篇文章,任务是半监督的短文本分类。由于短文本信息量少,而且通常标注的数据也不多,所以这里提出了一种Heterogeneous Graph Attention Networks。这个包括三种类型的节点:文档、topics、entities,其中topics是用LDA预先得到的,并把它作为节点,然后针对每个文档选top K个topics,并将他们相连。然后对网络进行更新。

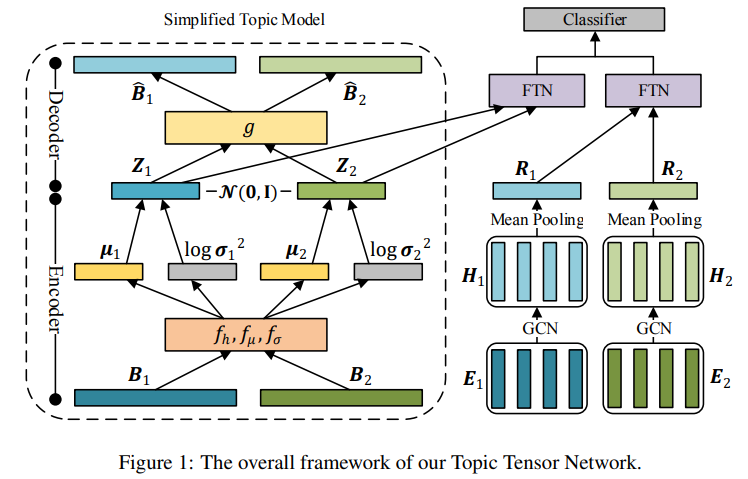

Topic Tensor Network for Implicit Discourse Relation Recognition in Chinese(ACL 2019)

如果说有的论文还尝试用attention将topic representation加入到semantic representation的提取过程中,这篇论文基本将topic representation和semantic representation提取的过程分开了。他用的STM、GCN和FIN我都不是很了解。我的理解是用STM得到raw topic representation,GCN得到raw semantic representation,然后用FIN进一步提取特征并分类。

Multi-Task Mutual Learning for Joint Sentiment Classification and Topic Detection(2019)

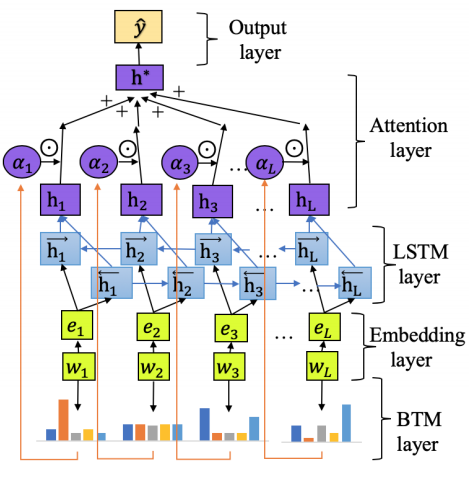

Latent Topic Attention for Domain Classification(INTERSPEECH 2019 CCF-C类期刊)

一般通过attention加入topic information都是通过vector使用类似于QKV的attention计算来得到。但是这篇论文不同,他根据topic-word矩阵定义了word的权重。但是这样对于所有文本一个word的权重都是不变的。

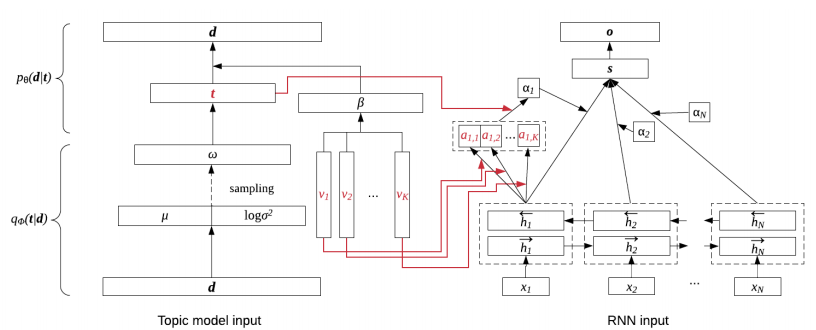

Neural Topic Model with Attention for Supervised Learning(PMLR 2020)

看着像是一篇好论文,但是其中NTM部分由于我对TM不熟跳过去了……

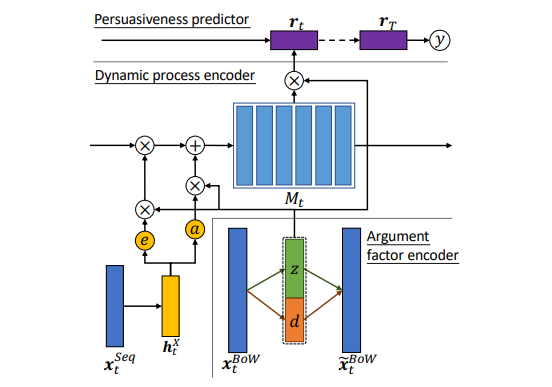

What Changed Your Mind: The Roles of Dynamic Topics and Discourse in Argumentation Process(WWW 2020)

这个模型也是完成论辩相关的任务。右下角的AFE就是一个topic model,然后通过设计了一个门操作来得到表示,比起attention见的还是少一点,不过在修改LSTM encoder门的操作还是挺常见的,但这个图画的挺好。

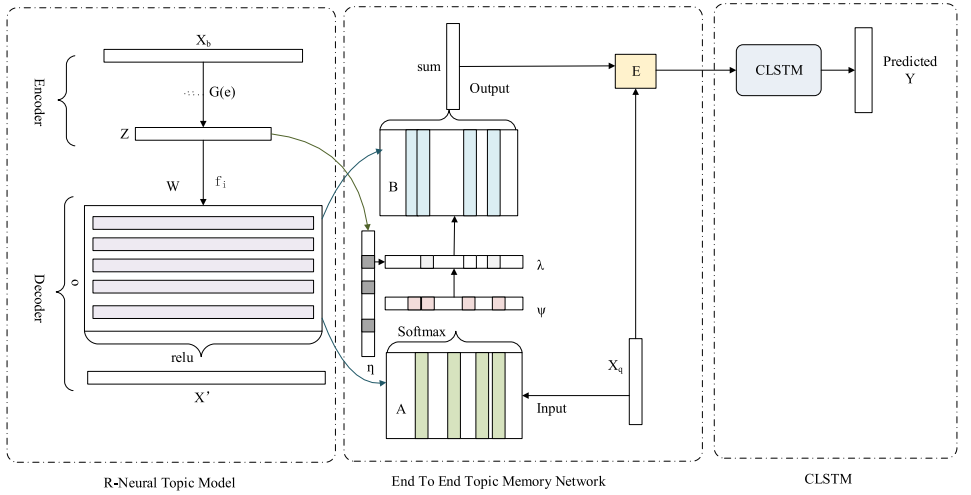

A CLSTM-TMN for marketing intention detection(Engineering Applications of Artificial Intelligence 2020 CCF-C类期刊)

要不是我看过“Topic Memory Networks for Short Text Classification”我还真的以为这是个Novel的方法。这两个除了任务不同大差不差。

Document and Word Representations Generated by Graph Convolutional Network and BERT for Short Text Classification(ECSI 2020 CCF-B类会议)

这篇论文处理的还是短文本的问题。针对短文本信息不足的问题,使用GCN来丰富信息。他的主要的创新点在graph的构建部分。graph共有3类节点:单词、文档、topic,边有的构建方式如下:

- 单词-单词:PMI

- 单词-topic:topic model的word-topic矩阵

- 单词-文档:TF-IDF

- 文档-topic:topic model的doc-topic矩阵

先用Bert得到特征,然后用GCN丰富特征并分类。

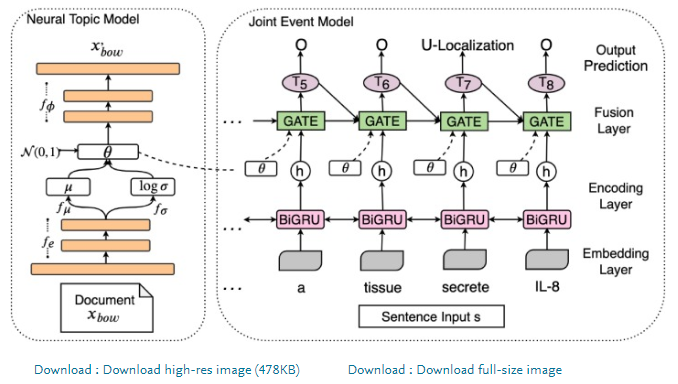

Topic-informed neural approach for biomedical event extraction(Artificial Intelligence in Medicine 2020 CCF-C类期刊)

这篇论文做的任务是医学方向的任务,但是模型还是熟悉的模型。他这里将NTM的信息融合方法改成类一个基于gate的方法,将h和 theta 作为输入,计算过程有点像GRU,虽然图上是序列形式的,会有gate状态的传递,但是更新公式中实际上只有考虑i-1的输出y_(i-1),并没有考虑细胞隐状态h。

by Mikito

by Mikito