【论文阅读】Earlier Attention? Aspect-Aware LSTM for Aspect Sentiment Analysis (IJCAI 2019)

Basic Information

- Authors: Bowen Xing , Lejian Liao , Dandan Song , Jingang Wang, Fuzhen Zhang , Zhongyuan Wang , Heyan Huang

- Institution: Beijing Institute of Technology, Meituan-Dianping Group

- Conference/Journal: IJCAI 2019

- Cite: Xing B, Liao L, Song D, et al. Earlier Attention? Aspect-Aware LSTM for Aspect Sentiment Analysis[J]. arXiv preprint arXiv:1905.07719, 2019.

Introduction

这篇论文是关于aspect-level的sentiment analysis。所谓的aspect,通常分为两种,一种是target,就比如例子“ Great salad but the soup tastes bad ”中的salad和soup都是在句子中给定的;另外一种就是category,比如例子“ Although the dinner is expensive, waiters are so warm-hearted!”其中要进行分析的aspect是price和service两个,这在句子中间没有出现,通常是事先确定的。 现在的Aspect sentiment anaysis通常对aspect的处理分为直接级联和使用attention加进来,而且很多使用的都是LSTM进行编码。在LSTM的编码过程中,当遇到了它觉得比较重要的词,就会将信息保存在cell里面,然后传递给下面的cell。但是这个重要是针对整句话的语义信息比较重要,而不是针对当前的aspect比较重要,所以即使编码之后使用attention机制可以得到较为理想的attention,也还是会存在无用信息的干扰。所以这里就提出了一个aspect-unaware的问题。这里给出了两个例子。还是对于“ The salad is so delicious but the soup is unsatisfied”这句话,在对soup这个aspect进行分析的时候,由于delicious对整个句子的语义也有很大的影响,所以也会在编码过程中保留下来,即使后来可以给unsatisfied比较大的权重,但是delicious这部分的信息也会保留在最后的表示中,并被放大。另外一个例子是“Pizza is wonderful compared to the last time we enjoyed at another place, and the beef is not bad, by the way.”这句话中Pizza的部分明显比beef部分多很多,所以在对beef进行分析的时候就会存在很多的无用信息,而且beef本身的信息会被弱化。

Method

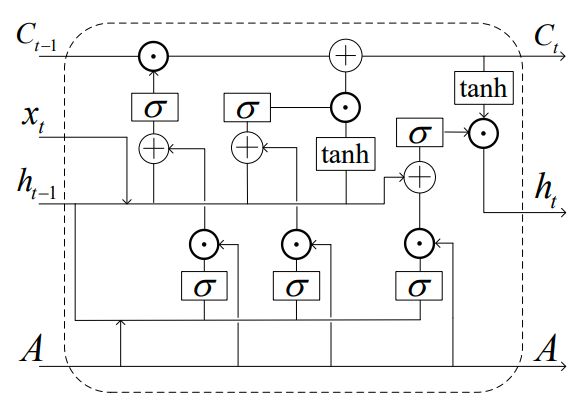

所以这篇文章提出了一个Aspet-aware LSTM,对原来的LSTM做了一些改进,在编码的时候就加入了aspect信息。下面是AA-LSTM的单元结构图:

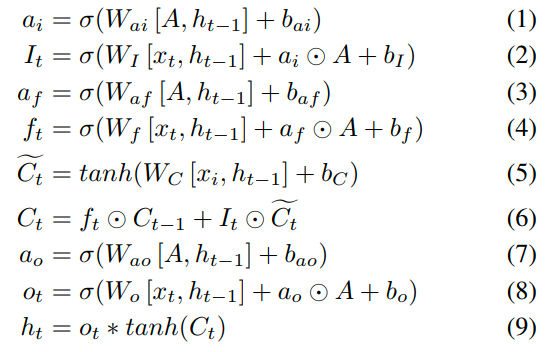

单元结构的上半部分就是传统的LSTM的结构图,所以AA-LSTM只是在原来LSTM的三个门的地方,用相同的操作也设计了三个门,用sigmoid函数控制aspect信息的流入,来将aspect信息加到原来的门中。右边是对应的公式,可以看出来,公式1,3,7是新增加。以输入门为例,a就是控制aspect流入输入门的。并且在整个单元构中,aspect只是用来控制信息流,并没有融入到最后的输出中。这篇文章中说,这样的结构可以提取出和当前aspect相关的关键信息,并且过滤掉无关的信息。

Experiments 下面就是文章的实验部分,他是选取了现有的三个模型,将其中的LSTM替换成AA-LSTM进行了对比实验,也直接用AA-LSTM进行了分类。实验结果表明是比LSTM的好的,而且只用AA-LSTM比现有的ATAE-LSTM好,证明了在编码过程中考虑aspect信息可能比之后的attention更有效。

Comments

其实我觉得这篇论文的创新点只有一个,就是对LSTM的一点改进,但是它的问题说的很清楚,强调的点也很明确。

by Mikito

by Mikito